在这篇文章中,我们介绍多项式朴素贝叶斯分类器是如何工作的,然后使用scikit-learn作为实际工作的示例来介绍如何使用。

与假设高斯分布的高斯朴素贝叶斯分类器相反,多项式朴素贝叶斯分类器依赖于多项分布。通过学习/估计每个类的多项概率来“拟合”多项式分类器-使用平滑技巧来处理空特征。MultinomialNaiveBayes(多项式朴素贝叶斯)是一种常用的文本分类算法,特别适用于处理多类别分类问题,例如文档分类、垃圾邮件检测等。它是朴素贝叶斯(NaiveBayes)算法的一种变体,主要用于处理特征是离散型变量的情况,通常用于文本分类任务中。

多项分布如果你已经熟悉多项分布,可以跳过这个部分。

了解多项式朴素贝叶斯的第一步是了解什么是多项分布。

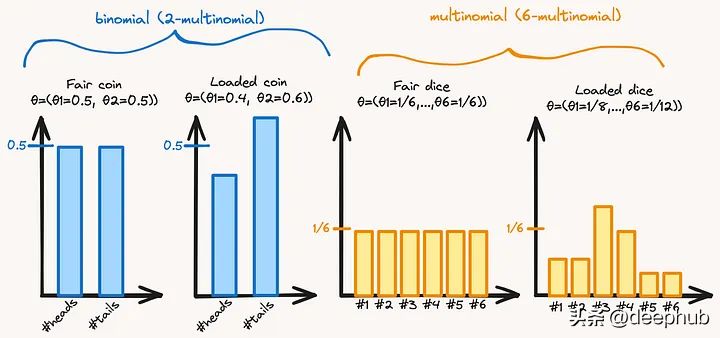

多项分布(MultinomialDistribution)是概率论和统计学中常用的一种概率分布,用于描述具有多个离散结果的随机试验。它是二项分布的推广,适用于多类别问题,例如投掷一枚骰子多次,每次可能得到1、2、3、4、5、6这六种结果的其中一种。

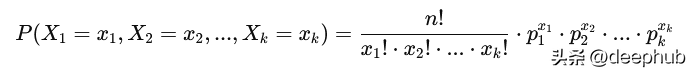

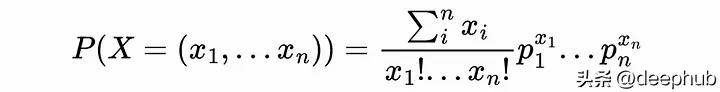

多项分布描述了进行nn次独立的多项试验时,各个类别的概率分布。如果一个随机变量XX表示了这些试验中各类别出现的次数,其中有kk个类别(例如在骰子的例子中就是6个类别),则多项分布的概率质量函数为:

多项分布是离散型的。与二项分布类似,但不同的是,二项分布只涉及两种结果,而多项分布适用于多种结果的情况。每个试验的结果可以是多个类别之一。多项分布中的概率质量函数考虑了各个类别出现的次数以及各类别的概率。

如果投掷一个六面骰子10次,每个面出现的次数是X1,X2,,X6X1,X2,,X6,那么X1+X2++X6=10X1+X2++X6=10。假设骰子是公平的,则每个面的概率是相等的,即p1=p2==p6=16p1=p2==p6=61。这时多项分布可以描述各个面出现次数的概率分布。

我们可以使用numpy随机选择函数模拟这样的分布。例如,从加载骰子分布中抽取100个样本:

loaded_dice_probs=[1/6,1/4,1/4,1/6,1/12,1/12]dice_faces=[1,2,3,4,5,6]n_try=100--array([17,26,21,18,8,10])

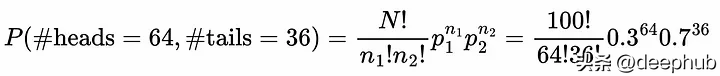

关于多项分布,另一个需要了解的重要的东西是概率质量函数。概率质量函数给出了从离散分布中观察到特定结果的概率。投掷100次,得到64次正面36次反面的概率为:

其实就是二项式定理。对于一个多项式定理,我们得到了多项式概率(p_1,…,p_n)和总尝试次数N=x_1+…+x_n的广义表达式:

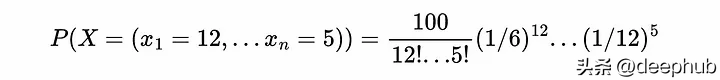

假设有一个装好的骰子,我们想计算这个骰子的分布是(1/6,1/4,1/4,1/6,1/12,1/12)的概率。掷骰子100次,得到x1=12面1,x2=15面2,然后我们可以计算观察到这样一个结果的概率:

这个示例展示了如何在给定相关概率(所有pi)的情况下计算观察给定结果(所有xi)的概率。这很重要,因为它将有助于计算给定样本X=(x1,…,xn)属于分类问题中可能的多项分布p=(p1,…,pn)的概率。

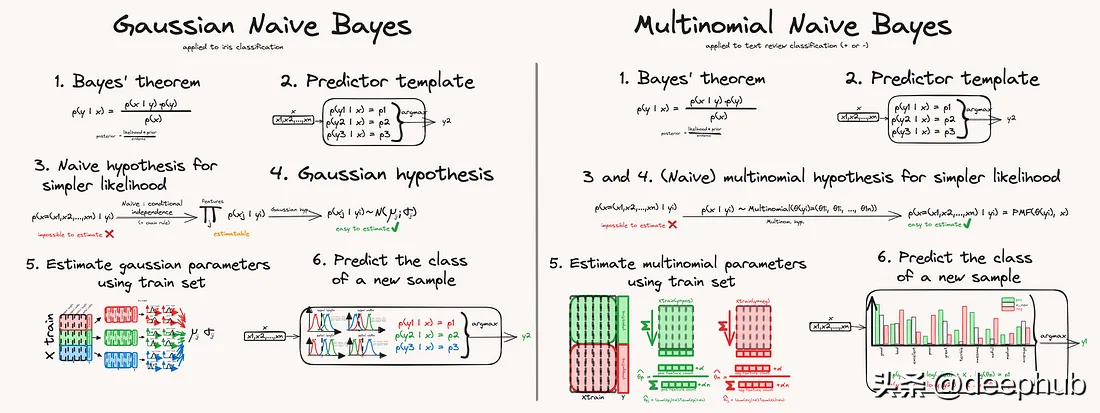

分类问题高斯朴素贝叶斯和多项是朴素贝叶斯实际上在原理上非常接近,主要是对潜在特征分布的假设不同:我们假设每个类别的每个特征都遵循高斯分布,而不是假设它们遵循多项分布。

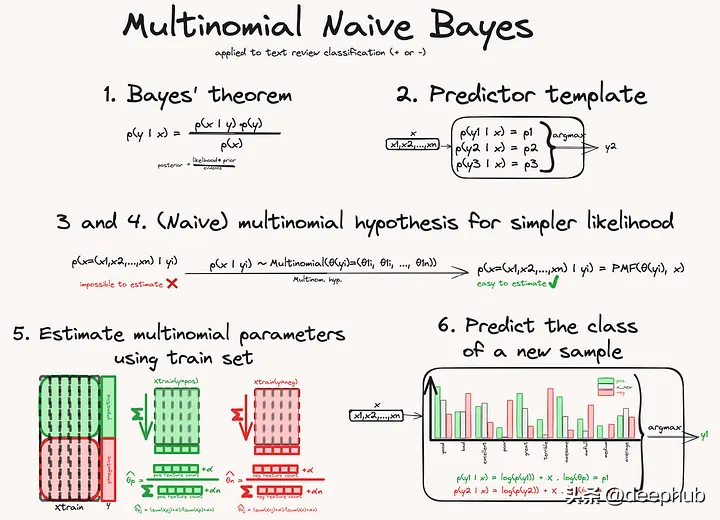

与高斯方法相比,在学习过程中估计分布参数的方式不同,在预测过程中使用分布参数的方式也不同。但总的来说,过程是相似的。以下是重要的步骤:

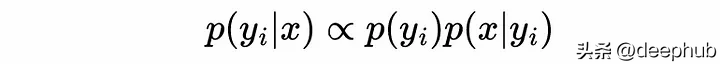

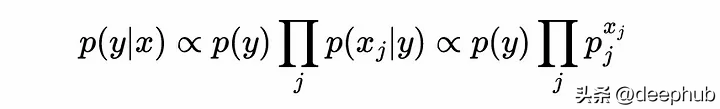

贝叶斯定理允许我们计算样本属于给定类别y的概率。创建一个空分类器,计算新样本属于所有类的概率,并返回概率最大的类。为了能够计算贝叶斯方程的概率,我们丢弃分母p(x),因为在比较每个类时它并不重要。然后需要使用假设所有特征都遵循多项分布来简化可能性项,对于每个类(朴素独立性实际上是内置在多项分布中的)。然后使用多项分布的概率质量函数来计算给定样本属于一类的概率。

这样就可以来拟合我们的模型,通过学习每一类的多项分布参数。一旦模型拟合就可以使用pmf来计算贝叶斯定理给出的最终概率,并返回最高概率类。

对于上面说的计算贝叶斯方程的概率

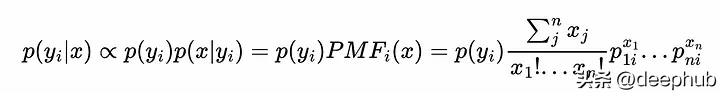

其中p(y_i)是任何样本属于类y_i的概率,这是由数据集中每个类的比例给出的——p(x|y_i)是一个样本等于x的概率,假设它属于类y_i:这正是PMF给我们的,或者说样本x属于y_i类的概率为:

式中p_1i为类i与特征1相关的多项概率。

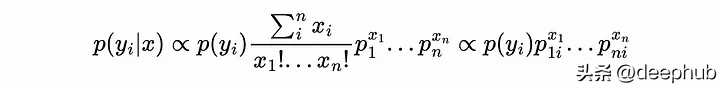

就像我们从贝叶斯方程中去掉分母一样,我们也可以去掉PMF的前导分数,因为它也只取决于x而不是类,所以最终得到:

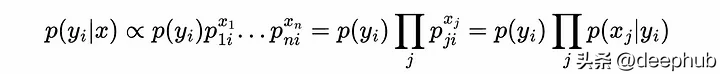

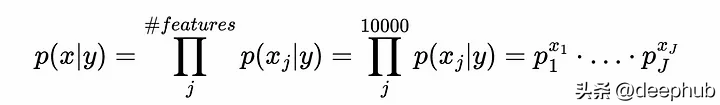

这意味着我们只需要估计每个类的多项概率,就能够计算一个样本属于任何类的概率。并且不需要像高斯方法那样使用链式法则和独立性假设。用独立概率项的乘积来表示它的另一种方法是:

与类先验(p(yi))成正比乘以p(xj|yi)的所有j的乘积,这是在给定样本属于类yi的情况下,观察到特征j的xj结果的概率。

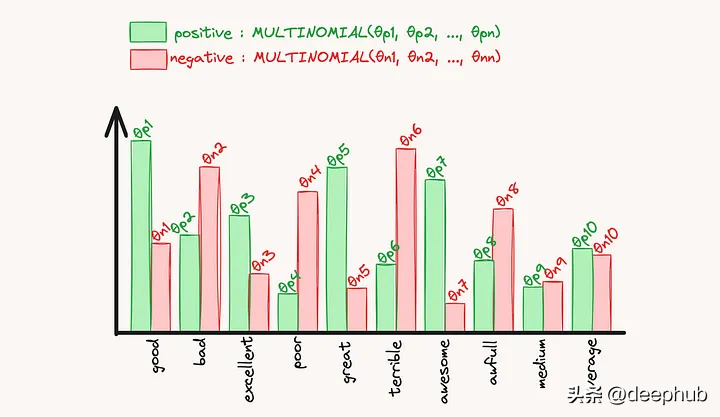

使用平滑技巧估计多项参数我们已经知道了如何计算一个给定样本属于一类yi的概率,现在需要估计多项概率参数,包括正分布和负分布。

我们将使用数据集的一部分,即“训练集”来训练我们的模型,以便它“学习”那些多项参数。这一部分解释了它是如何在数字上实现的。

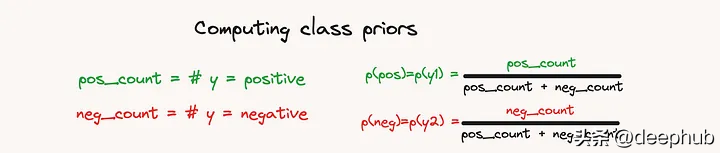

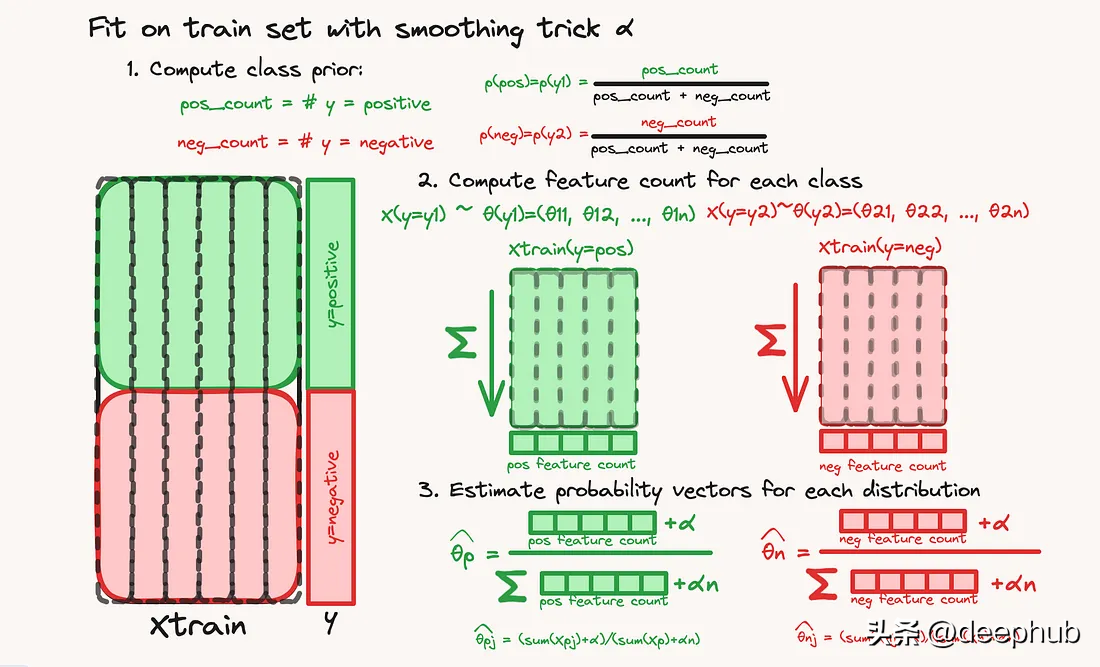

第一步也是最简单的一步是计算类先验,即观察到类yi的概率(与样本x无关),这是通过计算训练集中每个类的比例来完成的。

下一步是计算多项参数(对于pos和负数都是pj)。每个类都是独立于其他类处理的。对于每个类,X训练集对所有样本求和,因此我们计算一个“特征计数”向量:这个向量分布是真实底层分布的映射。然后将这些特征计数的向量转换为多项式分布参数的“有效”向量,将该向量除以总和。

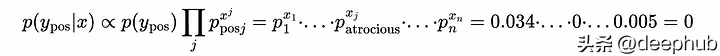

但是,如果一个类从未出现在类中,比如单词“atrocious”从未出现在训练集的正部分,该怎么办?那么,正类的相关概率θ_atrocious将为0(分子为0),这将导致该样本属于正类的总体概率也为0:

在学习过程中从未出现过“atrocious”这个词这一事实意味着,无论新样本的内容如何,任何新样本属于正类的概率都为0。或者说我们不能允许任何一类的多项式分布概率参数为0;否则,该类的总贝叶斯概率总是0。

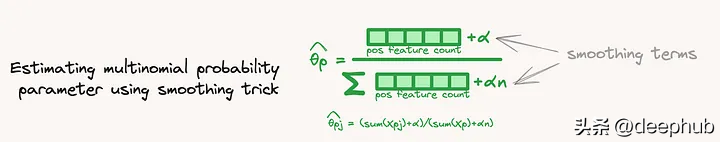

为了避免这种情况,我们使用了“平滑技巧”,即在估计概率参数时在分子和分母上都添加一个α项。这样,即使一个特征(一个词)在所有样本中都不存在,估计的学习概率也不会为0:

现在我们知道如何正确估计多项概率参数,可以继续预测新样本的类别。

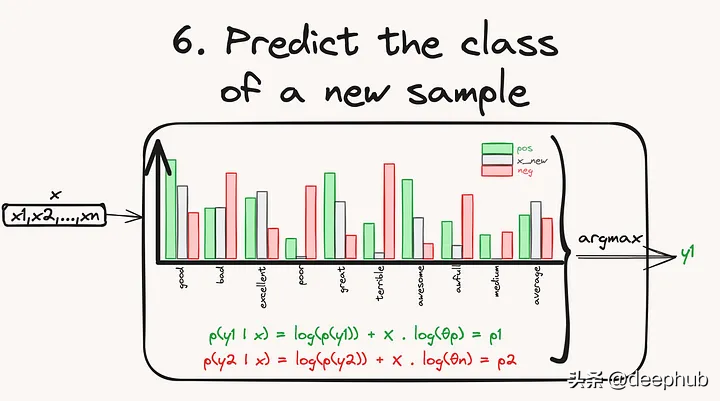

在对数空间计算预测,避免数值下溢现在我们有了计算每个样本属于任何类的概率所需的所有值,我们可以代入数字并执行计算来预测该类。

假设输入数据集包含1000或10000列(想想词表中的所有单词),其中许多单词非常稀疏地出现,使得它们的概率非常小。这将如何转化为给定类别y的总概率的计算:

其中x_j是样本x在第j列的值,p_j是该类的多项分布参数j的概率。

让我们通过创建一个包含300个样本、10000个特征列的数据集来模拟这一点,其值在1到50之间。在文本上下文中,这相当于300个文档,词汇表为100000个单词,其中每个文档中的每个单词出现1到50次。

importnumpyasnpJ=10000nsamples=300X=((1,50),size=(nsamples,J))estimatethedistributionprobabilitiesfeature_probs=X_(axis=0)/X_()print(feature_probs)1.09517582]

相应的概率是1e-4的数量级,这个数量级很小,计算机可以很好的处理这样的数字,所以现在没有问题。但是当计算样本属于一个类时,问题就出现了,这个概率如上所示,通过取所有p_j^{x_j}的乘积得到,其中p_j是单词j的估计概率,x_j是单词j在测试样本中出现的次数。我们得到:

Definethevocabularyvocabulary=['good','bad','excellent','poor','great','terrible','awesome','awful','fantastic','horrible']itisusuallycreatedwiththedatasetbutforthisweassumeitislimitedtothislistnotethatprobabilitiesfor"bad"wordsarenot0,sotheymightappearinpositivedocs,andviceversaLet'sploteachdistributiondf=({'neg':negative_probs,'pos':positive_probs},index=vocabulary)df_melted=_index(names='word').melt(id_vars='word',value_vars=['pos','neg'],var_name="class",value_name="prob.")g=(df_melted,y="prob.",hue="class",x='word',kind='bar')_xticklabels(_xticklabels(),rotation=90,ha='center',va='top')_title('Truedistrbutions')

我们只创建了两个多项式分布。使用它们并对它们进行采样以创建具有已知类的实际数据集。

create1000positivereviewsand1000negativereviews:ourdatasetisbalancednotethatthevocabularyofeachreview(=numberofdistinctword)maybedifferentn_samples=1000positive_docs=[''.join((vocabulary,size=(5,15),p=positive_probs))for_inrange(n_samples)]negative_docs=[''.join((vocabulary,size=(5,15),p=negative_probs))for_inrange(n_samples)]Combinedocumentsandlabelsdocuments=([positive_docs,negative_docs])labels=([labels_positive,labels_negative])()(CountVectorizer(vocabulary=vocabulary).fit_transform(documents).toarray(),xticklabels=vocabulary,cbar_kws={'label':'wordcount'})CreateaCountVectorizertoconvertdocumentsintoamatrixoftokencountsvectorizer=CountVectorizer(vocabulary=vocabulary)TrainamultinomialnaiveBayesclassifierclassifier=MultinomialNB(alpha=0)estimatedistributionparametsersourselvesfromscikit-learnstoredattributesthetas=(_count_.T/_count_.sum(axis=1)).Tprint(thetas)--array([0])我们还可以检查并尝试在对数空间中手动重现模型所做的计算。当你在模型上使用.predict_proba时,它只是取log-probs的指数:

x_new=[(X_test)[0].toarray()[0]]featurelogprint(_log_prob_)print((_count_.T/_count_.sum(axis=1)).T)(_log_proba(x_new))_prob_x=logsumexp(jll,axis=1)print(_2d(log_prob_x).T)finalprobprint(_proba(x_new))print((_2d(log_prob_x).T))

结果如下:

[-0.69439796-0.69189796][-0.69439796-0.69189796][[-3.38439026-2.23416174-3.3921724-1.78743301-3.25377008-1.90384336-3.24699039-1.54840375-3.36140075-1.69169478][-2.21004013-3.30382732-1.75312052-3.28949016-1.9058684-3.24767222-1.53889873-3.4984992-1.72443931-3.4306766]][[-3.38439026-2.23416174-3.3921724-1.78743301-3.25377008-1.90384336-3.24699039-1.54840375-3.36140075-1.69169478][-2.21004013-3.30382732-1.75312052-3.28949016-1.9058684-3.24767222-1.53889873-3.4984992-1.72443931-3.4306766]][[-16.67116009-20.94229983]][[-16.67116009-20.94229983]][[-0.01386923-4.28500897]][[-0.01386923-4.28500897]][[0.98622650.0137735]][[0.98622650.0137735]]

这里我们使用alpha=0可以轻松地手工重现计算,但由于这是一个超参数,因此可能需要对其进行调优。

总结多项分布是一种重要的概率分布,适用于描述多类别、多次试验的情况,是概率论和统计学中的基础之一。它表示实验可以有N个不同的输出,重复M次。可以把它看作投掷硬币的二项分布的概括,就像反复计算掷骰子的每面一样。多项式朴素贝叶斯分类器的总体思想与高斯朴素贝叶斯分类器非常相似,只是在拟合和预测计算上有所不同。为了学习每个类别的多项概率参数,可以简单地将训练集沿特征求和,并将结果除以该向量的和。这提供了对概率的估计。使用一个平滑的技巧可以处理在训练中未出现的特征。为了预测新样本的类别,则需要使用多项分布的概率质量函数,并在“对数空间”中计算所有概率,以避免下溢和计算机无法处理的小数字。

多项分布在实际中有广泛的应用,特别是在以下领域:

自然语言处理中的文本分类、主题建模等。

生物统计学中的多样性指数的计算。

计数数据的建模,如调查数据、市场调查等。

假设检验,用于检验多类别随机变量的比例是否满足某种期望。

作者:YoannMocquin